לאחר למעלה מעשור של ענישה ודיכוי, גוגל גרם לעלייתן ונפילתן של שיטות קידום מניפולטיביות. אנשי מקצוע רבים כמעט ושכחו את מרווח התמרון והיכולות הטמונות ב- on-page SEO ופועלים ברמה הבסיסית בלבד, בין אם מתוך זהירות ובין אם מתוך הרגל. לא, זה לא פוסט נוסף על אופטימיזציה של כותרות, מילות מפתח ותגיות. בפוסט זה אני הולך להציג רשימה של בעיות ופתרונות שיעזרו לכם לשפר דרוגים במנועי חיפוש בעזרת תיקון של אלמנטים בon-page מזוויות ושכבות פחות מדוברות, אך חשובות מאוד.

שיפור המוניטין וניהול יחסי הציבור של העסק שלנו זה בעצם ה-off-page, כאשר on-page שקול לכותלי החנות עצמה: המדפים, עמדת הקופה וכו'. לכל אחד משקל שונה, אך חשוב לדעת שאחד לא יכול להתקיים בלי השני. לעתים קרובות, בעלי עסקים מתעקשים לקבל הצעת מחיר חלקית אשר כוללת שיווק באמצעות תוכן בלבד, ללא עבודת on-page. הם כל כך בטוחים באמונתם שכל מה שצריך לעשות נעשה, אך המציאות שונה לחלוטין; ניתוח מהיר לרוב מראה קידוד והטמעה חובבנית בהיבטי ה- SEO השונים אשר מראש מפריעים לתהליך. השליטה המלאה ב-on-page נותנת כוח ויכולת להשפיע כמעט מידית על דירוגים, בניגוד לעבודת off-page אשר בדרך כלל לוקחת זמן, ותלויה בהרבה גורמים שעל חלקם הגדול אין לנו שליטה.

מטבע תפקידי ולאחר כמעט עשור של עשייה, נחשפתי להרבה סיטואציות מוזרות בהקשר זה, כמו גם לעובדות מעניינות. בפוסט זה ארכז מספר טיפים סביב on-page. הפוסט עוסק בסוגיות מתקדמות ולכן אני יוצא מתוך נקודת הנחה שהידע הבסיסי והיכולות הטכניות קיימים, משמע שלא ארחיב על כל דבר. אם בכל זאת משהו אינו מובן, אתם מוזמנים להשאיר שאלות בתגובות למטה.

הרשימה לא מסודרת על פי חשיבות. קחו נשימה עמוקה, ובואו נצלול.

1. מבנה קישורים פנימי שלא מספר סיפור

הסבר כללי: יצא לכם פעם לתהות מדוע לעמודי משנה כמו 'אודות' ו'צור קשר' יש PR ו-DA חזקים? בהרבה מקרים, אין להם אפילו קישורים חיצוניים. אז מה הסיבה? קישורים פנימיים! מבלי לדעת ובאופן טבעי אנו מצהירים שאלו עמודים מרכזיים. בדיקה מהירה תגלה כי זה נכון, והם מופיעים לרוב בתפריטים חוצי-אתר, אך הם לא תמיד חזקים כפי שנרצה שיהיו.

שיפור מבנה הקישורים הפנימיים הנו אחת השיטות החזקות בארסנל ה-on-page שלנו. כמעט תמיד אחרי סיום המשימה, בזחילה הבאה של גוגל אנחנו רואים שיפור במיקומים. השיטות להשגת היעד מגוונות, אך המתודולוגיה אחידה וידועה. אנקורים מספרים סיפור! אם ניקח את כל האנקורים באתר מסויים ונכתוב אותם ברצף, נקבל תמונה כללית של נושא האתר.

לרובוטי הזחילה אין העדפות אישיות, המשימה שלהם פשוטה ומחושבת. לכן אם נדע מה בדיוק הם עושים ומה הם מחפשים, נוכל לשפר עמדות. כאשר זחילה מתבצעת באתר, המעבר מעמוד אחד לעמוד אחר קורה דרך אותם לינקים פנימיים. המידע נאסף עד שהזחילה הסתיימה או שהגיעה ל-time out. ברוב המקרים יש נתח הזדמנות גדול ומבוזבז על השולחן אשר לא מנוצל כהלכה ואליו בדיוק אנחנו מכוונים.

מה הבעיה? כאשר אין מבנה קישורים פנימי ברור, האלגוריתם משייך פחות ביטויים רלוונטים לדפי הנחיתה החשובים באתר. הסימפטום העיקרי הוא שדף הבית משוייך עם רוב הביטויים שאותם אנחנו רוצים לקדם, אך מעטים מהם מגיעים לעמוד הראשון.

הפתרון: אם יש בלוג באתר, התחילו בקישור של 20-30 פוסטים (לא להגזים) לדפי נחיתה רלוונטים חשובים. כיתבו עוד 15-20 פוסטים חדשים שמעמיקים את הנושא המרכזי של דפי הנחיתה וקשרו מהם לפוסטים החדשים, ולהפך. מערכת הלינקים הפנימית צריכה לרמז על צמתי האתר המרכזיים בעזרתם של דפים ישנים ומאונדקסים וכן חדשים שהתגלו למנוע החיפוש.

הקפידו על תוכן איכותי שיעורר עניין, אחרת הדפים שמהם תקשרו לא יעשו את העבודה. שימו לב שלא הזכרתי באילו אנקורים להשתמש, מכיוון שזה פחות חשוב אם הדף שמקשרים ממנו רלוונטי. השתמשו באופן טבעי באנקורים שמתארים את דף היעד. גם "לחץ כאן" הוא אנקור מקובל ואפילו מומלץ מדי פעם כשמתאים.

הקפידו על תוכן איכותי שיעורר עניין, אחרת הדפים שמהם תקשרו לא יעשו את העבודה. שימו לב שלא הזכרתי באילו אנקורים להשתמש, מכיוון שזה פחות חשוב אם הדף שמקשרים ממנו רלוונטי. השתמשו באופן טבעי באנקורים שמתארים את דף היעד. גם "לחץ כאן" הוא אנקור מקובל ואפילו מומלץ מדי פעם כשמתאים.

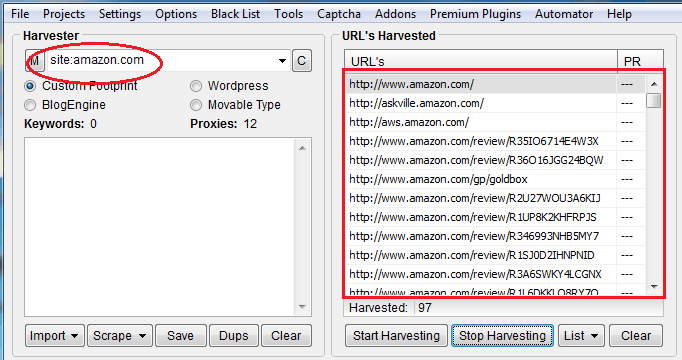

כעת, עליכם למצוא את הדפים החזקים ביותר באתר ומהם לקשר לדפי הנחיתה החשובים (אם אפשר). כאן אנו ממנפים כח קיים כדי לחזק דפים חשובים. לצורך זה נשתמש ב-ScrapeBox, נקליד

site:site-name.com ונלחץ Start Harvesting, לפי הדוגמה:

התוצאה תציג לנו את כל העמודים באתר. כעת נבדוק פופולריות וחוזק כך:

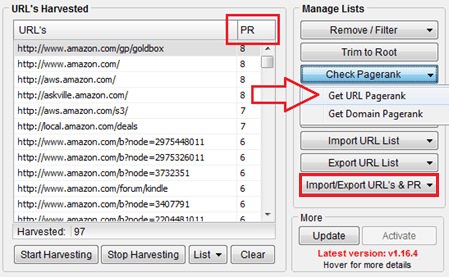

1. בדיקה של PR ואז יצוא של הנתונים מהתפריט הימני (קובץ CSV):

נכון ש-PR אינו המדד הכי אמין או מדויק, אך הוא עדיין מהווה אינדיקציה טובה וזה מה שזמין בתוכנה. כמובן שאותה בדיקה עםPA (page authority) תהיה הרבה יותר מדויקת, אבל היא תצריך חשבון ב-Moz ורישום של קוד API.

הערה: מי מכם שעבד בעבר עם ה-API של Moz, ידע שישנם אי דיוקים ולפעמים אף לא מוחזרים ערכים כלל. שימו לב לכך ובדקו ידנית כל תוצאה שנראית לכם חשודה. (חשוב לזכור כי מדדים אלו אינם מייצגים בהכרח את אותה החשיבות שהאלגוריתם מייחס לדף אך הם מספיקים על מנת לתת אינדיקציה)

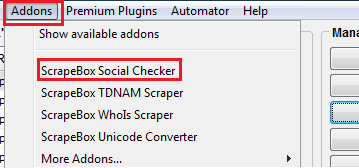

2. בדיקה של פופולריות ברשתות החברתיות, יצוא ואיחוד הנתונים עם הפלט הקודם:

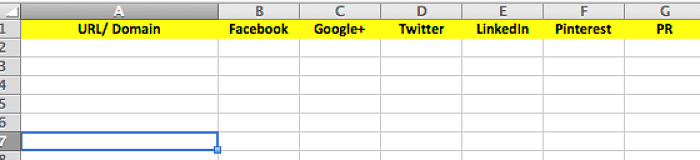

עכשיו אתם יכולים לאחד את שתי הטבלאות ולמיין את הנתונים איך שתרצו בכדי לקבוע אילו עמודים הכי חזקים, ואז לקשר מהם לעמודי הנחיתה החשובים. כך נראה הטמפלט של הקובץ שאני משתמש בו:

לבעלי אתר WordPress יש Plugins שיכולים לעזור בבנייה ובתחזוקה של מבנה הקישורים הפנימי:

https://wordpress.org/plugins/wp-internal-links-lite/

https://wordpress.org/plugins/seo-automatic-links/

2. שורש ספריית קבצים מבלבל

הסבר כללי: סביר להניח שזהו אחד האלמנטים באתר שלכם אשר מקבל הכי מעט תשומת לב. זה מחסן הגרוטאות או עליית הגג החשוכה שאף אחד לא חושב יותר מדי על מה שבאמת קורה שם. גוגל מגיע לביקור באתר שלכם לכמה שניות בודדות, זוחל ואז עוזב. מיקסום זמן הביקור הקצוב יכול לעשות פלאים.

מה הבעיה? בוני אתרים, מקדמים, וגם בעלי האתר עצמו פשוט זורקים לספרייה הראשית וגם לספריות המשנה קבצים ללא הרף. כל עוד זה לא ויזואלי, זה לא מהווה בעיה מבחינתם, אך לכל קובץ יש השפעה והבעיה העקרית היא בדילול המידע הרלוונטי "בקבצי זבל", כגון:

• קבצי גירסאות שונות

• קבצי ניסיון

• קבציPDF/DOC לא בשימוש

• ספריות גיבוי

• תמונות/וידאו/מוזיקה (מקומם של קבצי מדיה בספריות ייעודית)

• קבצים זמניים

למרות שקבצים אלו לא בשימוש, הם כן נלקחים בחשבון בכל זחילה מה שמונע מכם למקסם את המשאבים שמוקצים לכם ואף גרוע מכך, מדלל את המידע החשוב באתר.

הפתרון: תעשו סדר! פתחו ספריה וקראו לה old-files. הכניסו לספרייה החדשה את כל הקבצים שלא בשימוש. כמו כן, מיינו את קבצי המדיה וספריות המשנה ואל תשכחו לעדכן את הכתובות החדשות בקוד איפה שנעשה בהם שימוש. אל תטרחו למצוא כל קישור שמצביע אליהם, פשוט בצעו את השינויים ואחר כך הריצו תוכנה לבדיקת קישורים שבורים ותקנו את מה שצריך. לצורך זה, אני משתמש ב- xenu link sleuth. לבסוף, עדכנו את קובץ robots.txt עם השורה הבאה:

Disallow: /old-files/

3. כפילות תכנים מתחת לאף:

הסבר כללי: האם יש עונש על כפילות תוכן? כן, אבל רק במקרים קיצוניים. ברמה העקרונית כפילות תוכן לבדה אינה מהווה עילה מספיקה למתן עונש למעט מקרים בהם גוגל מזהים כי כפילות התוכן נעשתה בכוונה ובמטרה "לתחמן" את מנוע החיפוש. המקרה היותר נפוץ הוא הפחתת ערך (Devaluation). בכל תוצאת חיפוש יש אלפי תוצאות באינדקס. גוגל נותנים לנו גישה ל-1000 הראשונות, כלומר 100 דפים. אף אחד כמעט לא מתעניין מה יש בדף עשר מעצם הסיבה שהורגלנו שמה שמדורג גבוהה יותר כנראה יותר רלוונטי ומהימן. כטבע שני אנו סומכים על גוגל והם לא רוצים לאכזב אותנו. תוכן כפול או דומה מהווה אתגר לא קטן לגוגל, והם נחושים לדבוק במטרה ולשמר את חווית המשתמש ברמה גבוהה.

אם כך, אלף התוצאות הראשונות הן בעצם רשימה כרונולוגית ארוכה אשר ממויינת גם לפי רלוונטיות וסמכותיות. עם זאת, על כל רשימה כזאת חלים גם פילטרים כדי לשמור על איכות הפלט. כפי שבטח ניחשתם, אחד מהפילטרים מזהה כפילויות ודמיון בתוכן.

מה הבעיה? כמו כדור ברזל על שרשרת, תוכן כפול או דומה מהווה משקולת על האתר והופך את כל העבודה שאנו עושים סביבו ליותר קשה. באופן תאורטי, גם דף מועתק יכול בסופו של דבר להכנס לדף ראשון אם גורמי דירוג אחרים יעצימו את חוזקו יותר מחוזקם של דפים מתחרים. כמובן שהמאמץ יהיה הרבה יותר גדול וזה בדרך כלל יתבטא בזמן ובכסף. תוכן כפול או דומה גורם להפחתת ערכם של דפים בודדים, חלקים מאתר ואף אתר שלם, וברוב המקרים אנו אפילו לא יודעים על זה.

הפתרון: אגע קלות בכל אחת מהסיבות, ובמשפט-שניים אתאר את הפתרון. בעיקרון, גוגל יודע להתמודד עם רוב הבעיות אך בהחלט יעדיף אתרים מתוחזקים ובנויים כראוי מלכתחילה.

א. גירסאות שונות של כתובת האתר הראשית:

עם או בלי www, עם או בלי index.php/html בדף הבית. כל הגרסאות קוראות לדף הבית והתוצאה דומה, אך אלו עמודים זהים לחלוטין ויש סיכוי שכולם מאונדקסים בגוגל:

הכניסו את שתי השורות האלו בקובץ .htaccess (החלף domain בשם האתר. החלף html ב-php אם רלוונטי):

RewriteEngine On

RewriteCond %{THE_REQUEST} ^[A-Z]{3,9}\ /index\.php

RewriteRule ^index\.php$ / [L,R=301]

RewriteCond %{HTTP_HOST} ^www\.domain\.com$ [NC]

RewriteRule ^(.*)$ https://domain.com/$1 [L,R=301]

ב. גרסה מאובטחת וגרסה רגילה – http -> https. במעבר בין גרסת אתר רגילה למאובטחת הכניסו את הקוד הבא לקובץ ב-.htaccess (החלף domain בשם האתר):

RewriteEngine on

RewriteCond %{SERVER_PORT} !^443$

RewriteRule ^(.*)$ https://www.domain.com/$1 [NC,R=301,L]

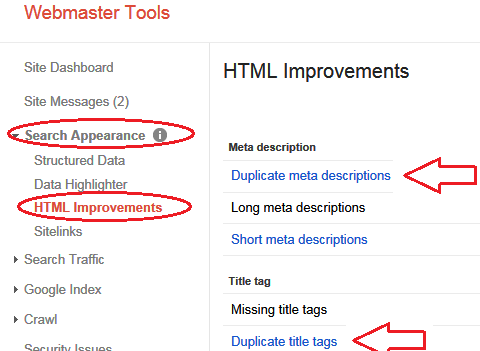

ג. כפילויות של כותרות ותאורי דפים – גוגל מגיש לכם את הנתונים הללו על מגש של כסף ולכן מצפה שתעשו איתם משהו. כנסו ל-Google Webmaster Tools, תקנו את הכפילויות ובאותה הזדמנות תבחנו את שאר ההמלצות והבעיות המופיעות שם.

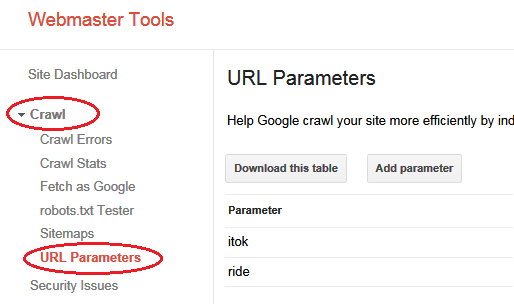

ד. דפים פנימיים עם פרמטרים – הרבה אתרים משתמשים בגירסאות URL שונות לצורך מעקב וניתוח. כמו כן, ישנן סיבות מגוונות אשר בגינן דפים יקבלו כתובות שונות כאשר כולן מובילות לאותו עמוד. גם כאן גוגל מושיט יד ומציע כלי קל לשימוש שנמצא ב-Webmaster Tools.

הגדירו פרמטרים שגוגל ידע מראש לפיהם מה נחשב לתוכן זהה, ויתייחס לכתובות הללו בהתאם. תוכלו למצוא הרחבה על הנושא בפוסט הזה מאת גוגל. עדיף להגדיר מראש את הפרמטרים כיוון שלאחר שהם מתאנדקסים יקח זמן רב עד שגוגל נפטר מהם לחלוטין.

ה. חפשו תוכן כפול בעזרת CopyScape וטפלו כראוי.

ו. הפחיתו תוכן דומה בעזרת איחוד דפים דומים. תנו העדפה ליצירת דפים מפורטים שמכסים נושא שלם על פני תתי נושאים כאשר לכל אחד מהם דף ניפרד. אם החלטתם לעשות זאת עם תוכן קיים, אל תשכחו לעשות הפנייה קבועה מהדף שבוטל לדף המעודכן שכולל פירוט רחב על הנושא.

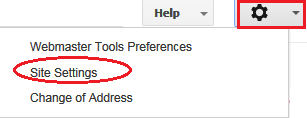

ז. הגדירו העדפה של סוג כתובת ב-Google Webmaster Tools עם או בלי www

ח. השתמשו ב-rel=”canonical” כשצריך להגדיר דף פנימי כזהה לדף אחר. ראו קוד לדוגמה:

<link href="https://www.example.com/canonical-version-of-page/" rel="canonical" />

קראו כאן על הנושא בהרחבה.

4. מהירות טעינת אתר

הסבר כללי: בעיני גוגל, מתן חווית משתמש גבוהה באה לידי ביטוי בהנגשת המידע בצורה הכי מהירה ומדוייקת, במטרה לעזור לו למצוא את מה שהוא רוצה הכי מהר שאפשר. ככל שאתם מבלים פחות זמן בכל סשן חיפוש בגוגל, מבחינתם זה יותר טוב ונחשב להצלחה. אצלכם באתר זה בדיוק הפוך, אתם צריכים לשמור את מבקרי האתר אצלכם זמן ארוך ככל שאפשר (מלבד ביטויים הקשורים למציאת כתובת, טלפון וביטויים נוספים הקשורים למידע מהיר – סוגיה מעניינת בפני עצמה אך זה נושא לפוסט אחר). מהירות טעינת האתר נחשבת למדד חווית משתמש מחשיבות עליונה. אם האתר שלכם נטען במהירות ממוצעת ומטה, כנראה שאתה משלמים על זה ביוקר וחלק מהגולשים עוזבים יותר מהר מהממוצע. גוגל שם לב לכך, מודד ו'מעניש' בדירוגים לפי התוצאה.

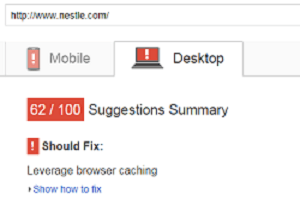

מה הבעיה? ישנם מדדים שונים לחווית משתמש, אחד מהם הנו מהירות טעינת האתר בגירסת מחשב שולחני ובמכשירים ניידים. אתר שנטען לאט יספוג פגיעה. כבר ב-2011 מאט כץ הודיע שמהירות טעינת אתר משתכללת בדירוג אתרים וככל שעבר הזמן אנו נוטים להאמין שהנתון הזה קיבל יותר משקל. שלוש שנים אחרי, אני יכול להגיד בוודאות ששיפור מהירות טעינה כמעט תמיד משפר מיקומים.

הפתרון: קודם כל, עליכם לבדוק מה המצב הנוכחי. אני תמיד מעדיף להשתמש בכלים שגוגל מספק כי הם מותאמים למדידות שהם עושים בפועל. בדוגמה הבאה אראה כיצד להשתמש בשני כלים כדי לקבל תמונה רחבה יותר על הבעיה וכן לפתור אותה.

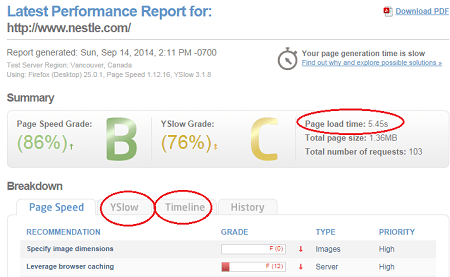

א. PageSpeed Insights נותן ציון לאתר על פי זמן טעינה, מ-0 (הכי איטי) ל-100 (הכי מהיר). גוגל נותן לעצמו ציון של 99 ואני ממליץ לכוון ל-70 ומעלה. כל תחום ציונים מקבל צבע, תשאפו להיות לפחות באזור הצהוב (65 ומעלה):

לאחר הבדיקה, תקבלו המלצות לשינויים ופירוט כיצד ליישם כל אחת מהן.

ב. GTmetrix יתן לכם תמונה קצת יותר מפורטת, אך למרות זאת, בסיום התהליך נסו לכוון להשביע את רצונו של Google PageSpeed Insight. הסיבה שאני משתמש בכלי נוסף הינה שגוגל לא תמיד מפרט את כל הגורמים המשפיעים ואני מעדיף לבצע עבודה יסודית ככל שאפשר. התרכזו בכרטיסית YSlow. ניתוח על ציר הזמן יכול להתבצע בכרטיסיית TimeLine:

לניתוח מתקדם בזמן אמת תוכלו להתקין את ה-Plugin הבא בדפדפן שלכם: https://yslow.org/

לתיקון מהיר ומבלי להתעסק יותר מדי בקוד, התחילו עם ארבע ההמלצות הבאות ולאחר מכן שפרו עמדות לפי ההמלצות של שני הכלים הנ"ל:

א. עשו אופטימיזציה לכל התמונות באתר (ספריית התמונות הראשית שלכם). הכלי הכי פשוט ויעיל לעשות את זה נקרא: Yahoo! Smush.it. הכלי פשוט וקל לשימוש.

ב. אפשרו דחיסה בעזרת שימוש ב-GZIP. פשוט הכניסו את הקוד הבא לקובץ ה-.htaccess

AddOutputFilterByType DEFLATE text/plain

AddOutputFilterByType DEFLATE text/html

AddOutputFilterByType DEFLATE text/xml

AddOutputFilterByType DEFLATE text/css

AddOutputFilterByType DEFLATE application/xml

AddOutputFilterByType DEFLATE application/xhtml+xml

AddOutputFilterByType DEFLATE application/rss+xml

AddOutputFilterByType DEFLATE application/javascript

AddOutputFilterByType DEFLATE application/x-javascript

ג. הקצו פג תוקף לקבצים. פשוט הכניסו את הקוד הבא לקובץ ה-.htaccess

<IfModule mod_expires.c>

ExpiresActive On

ExpiresDefault "access plus 1 month"

ExpiresByType image/x-icon "access plus 1 year"

ExpiresByType image/gif "access plus 1 month"

ExpiresByType image/png "access plus 1 month"

ExpiresByType image/jpg "access plus 1 month"

ExpiresByType image/jpeg "access plus 1 month"

ExpiresByType text/css "access 1 month"

ExpiresByType application/javascript "access plus 1 year"

</IfModule>

ד. השתמשו ברשת אספקת תוכן CDN. זהו שירות שבדרך כלל מסופק מחברת אחסנת האתרים שלכם.

5. שקיפות מלאה וחשיפה של גורמים זדוניים

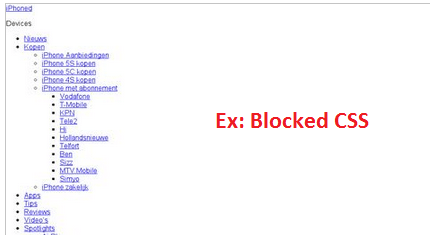

הסבר כללי: חסימה של קבצים מסויימים ונוכחות של אלמנטי קוד כאלה ואחרים לפעמים מחייבים את גוגל להניח הנחות שפוגעות בנו. גוגל לא יכול לדעת הכל על האתר שלכם ולא בוחן אתרים בצורה ידנית, ולכן אנחנו צריכים להיזהר לא לייצר אותות שליליים שלא במודע.

מה הבעיה? חסימה או נוכחות של אלמנטים כאלה ואחרים באתר גורמת לגוגל לבחור בדרך הבטוחה יותר ולשפוט נגדנו גם אם לא הוכחה אשמתנו במניפולציה.

הפתרון: עברו על הנקודות הבאות וודאו שאתם לא שולחים אותות שליליים או מבצעים עבירות שלא במודע:

א. אל תחסמו את קבצי ה-CSS וה- JS שלכם ב-robots.txt. גוגל מייחס לזה חשיבות רבה. עדיין לא ברור אם זה מקדם בטחון כיוון שספאמרים משתמשים בקבצים אילו למניפולציות תוכן שונות, או שזה מכיוון שרובוטי הזחילה רואים דף שבור/חסר מעצם העובדה שהקוד לא נגיש להם:

היזהרו גם לא לחסום את קבצי הטמפלט (שזה, דרך אגב, חוסם גם CSS & JS). זאת טעות נפוצה והרבה חושבים שחסימה של קבצים אלו עוזרת לנווט את גוגל לקבצי תוכן במקום קבצי קוד. זה לא נכון! לבעלי אתר WordPress מותר לחסום את ספריית ה-Plugins, ואפילו מומלץ.

ב. נכון, גוגל יודע לקרוא רק טקסט, אבל נוכחות של תמונות חשובה ואפילו מומלצת. אל תחסכו מגוגל לזחול בספריית התמונות שלכם. חסימה של הספרייה תגרום לכל קבצי התמונות לא להיות מאונדקסים, מה שיפחית את כמות התוכן שמשויך לאתר שלכם. אין הוכחה ישירה שזה משפיע על SEO (דירוג) אבל זה לחלוטין יכול להכניס לכם תנועה נוספת דרך מנוע התמונות של גוגל. אם אין סיבה מוצדקת לחסימה של מדיה, הייתי פשוט ממליץ לכם להימנע מלעשות זאת.

ג. אל תחסמו את ספריית ה-RSS Feed. מקור מידע זה חשוב לגוגל (ולכם, תלוי איך מסתכלים על זה) אפילו יותר מ-Sitemap.

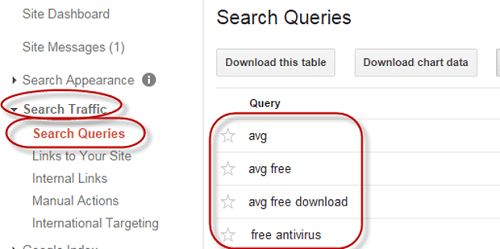

ד. בבדיקה שגרתית אחת לחודש הייתי ממליץ להציץ על רשימת שאילתות החיפוש ב- Google Webmaster Tools. שם תוכלו לראות אם האתר שלכם מקבל תנועה ממילות מפתח שלא קשורות לאתר שלכם. ודאו כי האתר שלכם מקבל תנועה אך ורק מביטויים הקשורים לתחום שלכם. מילים אשר צריכות להדליק אצלכם נורה אדומה יהיו מתחומי אתרים למבוגרים, תרופות, הלוואות וכו', בהנחה שאתרכם אינו עוסק בתחומים הללו. בבדיקה כזאת תוכלו לדעת באופן כמעט בטוח האם האתר נפרץ והושתלו בו דפים נוספים שמנצלים את חוזקו שלכם למטרות דירוג בגוגל.

ה. בדקו ב- Google Webmaster Tools תחת הספרייה. Security Issues.

ו. העזרו בכלי סריקה לפחות אחת לחודש. הירשמו בתשלום לבדיקה יומית:

https://sitecheck.sucuri.net/

https://www.sitelock.com/

ז. בדקו את הקוד שלכם. חיפוש קוד חשוד נעשה אוטומטית בעזרת הכלים הנ"ל. אני ממליץ לעשות את החיפושים הבאים ידנית:

<script>function מלווה במספר ארוך

text-indent: מלווה במספר גדול יותר מ-300 או קטן יותר מ-300-

hxxp:// מלווה בכתובת

חיפוש חוצה אתר יכול להתבצע בעזרת Dreamweaver או תוכנה דומה. תצטרכו לגבות את האתר לספרייה מקומית שזה מלכתחילה רעיון לא רע שצריך להעשות כל כמה שבועות, בנוסף למה שחברת אחסון האתרים שלכם עושה.

**יש להתייחס לכל תוצאה שנמצאה בחשדנות, אך לא להסיק אוטומטית שהקוד זדוני.

ח. בדקו את הלינקים שלכם ולאן הם מובילים. העזרו בכלי הבא בכל העמודים החשובים באתר:

https://www.unmaskparasites.com/

6. קישורים שבורים ומחזור כתובות אבודות

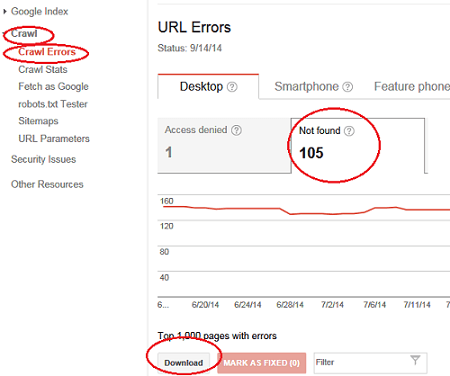

הסבר כללי: תחזוק שוטף כולל סריקות תקופתיות חשוב כדי להבטיח חווית משתמש מרבית. גוגל מבין את הדינמיקה באינטרנט, ומודע לחוסר השלמות שמאפיינת כל אתר חי ועובד. לכן אין שום חשש לענישה אם קישורים נופלים פה ושם, אך כן צריך להתחיל לדאוג ממצב המשדר הזנחה. זה יכול להתבטא במספר גדול (מאות) של קישורים שבורים שמופיעים ב- Google Webmaster Tools או עליה מתמדת של בעיות זחילה במקום ירידה. שוב, גם כאן אני משתמש בנתונים שגוגל נותן ומנסה להחזיר את המאזן הטבעי.

מה הבעיה? קישורים שבורים פוגעים בחווית המשתמש ובמקרים חריגים גם משדרים סימני הזנחה של האתר. נוכח הקישורים השבורים אנו מאבדים כח שנצבר וכתוצאה מכך האתר מאבד מכוחו הכללי. ירידה בכח ובערך האתר לרוב נובעת מכתובות אבודות.

הפתרון: ניתן לפתור בעיה זאת בשני שלבים:

א. הריצו בדיקה ב- xenu link sleut ותקנו כל קישור שבור.

ב. כעת טפלו בכתובות האבודות. מתוך Google Webmaster Tools מצאו את רשימת הכתובות השבורות וייצאו את הנתונים לקובץ CSV:

שמרו רק את עמודת ה-URL ומחקו את כל היתר. חשוב לדעת שאף על פי שהכתובות שבורות, חלקן עדיין בעל ערך שחבל לוותר עליו. אם לא בצעתם את התהליך הזה בעבר יכול להיות שמספר הכתובות בקובץ יגיע למאות ולפעמים לאלפים. זה בהחלט הופך את התהליך למייגע אך בתחזוקה תקופתית יקח לכם דקות ספורות לבצע את התהליך.

עכשיו, יש למצוא את הרשומות בעלות הערך. מחקו את הכתובות שתוקנו בשלב בראשון. עכשיו סמנו בצבע את כל הכתובות שאתם יודעים מראש שהן בעלות ערך (אולי פוסטים/עמודים פופולריים ישנים שמסיבה כלשהיא החלטתם למחוק וכו'). עכשיו בידקו PR ואותות מרשתות חברתיות כפי שעשינו בסעיף 2). סמנו באותו צבע את כל אלו עם PR אחד ומעלה, ואת כל אלו עם אותות חברתיים גבוהים (קבעו בעצמכם רף מינימום יחסי לפי הממצאים).

עכשיו נמצא לכל דף שבור מחליף ונכתוב פקודת הפנייה קבועה לפי התבנית הבאה:

Redirect 301 /old-url.php https://www.website-name.com/new-url.php

עכשיו יש לכם רשימה של כל הכתובות האבודות בעלות ערך עם הפנייה קבועה לכתובות החדשה. העתיקו רשימה זאת והכניסו לקובץ ה-.htaccess

7. תיקון שגיאות והסרת קוד מיותר

הסבר כללי: שגיאות וקוד מיותר יכולים לעכב זחילה ולרמז על אתר לא מתוחזק. כמו קישורים שבורים, גם טעויות קוד מתקבלות בהבנה כחלק טבעי מכל אתר אך עד גבול מסויים. ברוב המקרים, מספר הטעויות לא משקף את רמת התחזוקה, אלא סוג הטעות וגודל ההשפעה שלה. יכול להיות ש-100 טעויות שמצאתם לא בהכרח מצריכות תשומת לב ולא משפיעות כלל אך לעומת זאת טעות אחת קריטית יכולה לגרור אחריה הרבה סיבוכים והשלכות שליליות.

מה הבעיה? אתרים בני מספר שנים לרוב סובלים מקוד מנופח, מיותר ומלא שגיאות אשר גורם לחוסר יעילות ומצביע על אתר לא מתוחזק.

הפתרון: בשני שלבים:

א. אתרו את שגיאות הקוד ותקנו מה שאפשר, באמצעות:

https://validator.w3.org/

https://jigsaw.w3.org/css-validator/

ב. הסירו קוד מיותר (בצעו גיבוי לפני שמתחילים):

1. הסירו קודי מעקב לא בשימוש – הרבה פעמים אני מוצא קוד אנליטיקס ו- WMT כפול

2. הסירו חלקי קוד שאינם בשימוש (commented out)

3. הסירו כל קוד אחר שאתם בטוחים שלא בשימוש

4. הסירו את תג ה- meta keywords

5. הסירו הערות לא בשימוש (לא להסיר הערות שעוזרות להבין את השתלשלות השינויים בקוד).

8. אינדקס סמנטי חבוי ומילות מפתח איפה שצריך

הסבר כללי: אי אפשר שלא לדבר על מילות מפתח, אך הפעם מזוית שונה. מיקום מילות מפתח במקומות חשובים ושימוש ב-LSI (אינדקס סמנטי חבוי) חשובים כדי לקבל קרדיט מלא על התוכן.

LSI – משווקים באינטרנט, כותבי תוכן, ומעצבי אתרים לעתים קרובות משתמשים ב- LSI בכתיבת התכנים שלהם כדי להעשיר את התוכן במילים וביטויים שקשורים לנושא כגון מילים נרדפות ותוכן שבאופן טבעי יהיה קשור לנושא. לדוגמה:

Synonyms for “economical” = inexpensive, cheap, cost-effective…

Related to the subject “Dog” = breed, pound, names, adoption, the bounty hunter…

מרביתנו לא פסיכולוגים, אך גוגל משקיע הרבה משאבים ולא מעט ניתוח פסיכולוגי בכל הקשור להתנהגות גולשים שעוזר להם כמובן להחזיר תוצאות יותר איכותיות. הבנה של אופן סריקת דף וניתוחו בצורה אנושית עוזר בבניה של אלגוריתם מתוחכם יותר. אם נדע למה לכוון בכתיבת התוכן שלנו, נוכל להשיג תוצאות טובות יותר.

מה הבעיה? דפי נחיתה דלילים בתוכן או בעלי תוכן אשר לא בנוי נכון, מדורגים נמוך.

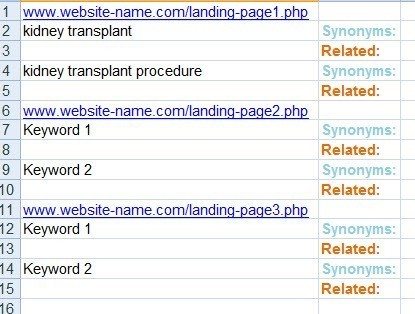

הפתרון: המטרה היא להעשיר את התוכן בצורה טבעית שתורמת למשתמש. ביצוע המשימה מתבצע ברמה של דף כמובן. אחרי שבחרתם דף שעליו אתם רוצים לעבוד, רשמו את מילות המפתח שתרצו לקדם:

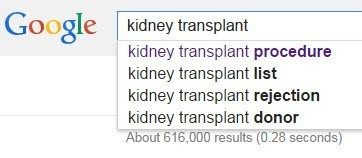

לכל מילה בביטויים שבחרנו נמצא מילים נרדפות ומילים שקשורות לנושא. מילים נרדפות אפשר למצוא בכל מילון. מילים שקשורות לנושא אפשר למצוא בגוגל. תקלידו את המילה, לחצו על מקש הרווח ואז תשקלו את מה שגוגל ממליץ:

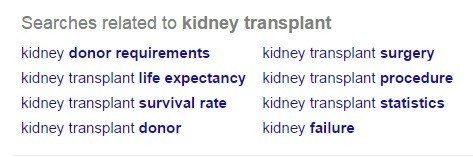

אם עדיין לא מצאתם מה שחיפשתם, לחצו 'חפש' ותגללו עד סוף הדף:

כאשר קובץ האקסל מוכן, תתחילו לעשות שינויים בטקסט ולוודא שכמה שיותר מילים מהרשימה שלכם יופיעו באופן טבעי בעמוד הנחיתה. היזהרו שלא לעבור את גבול הטעם הטוב. המטרה היא לשפר את כיסוי הנושא, לא לדחוס מילות מפתח, פעולה אשר תעמיד את האתר בסיכון לעונש ועלולה לגרום לתוצאה הפוכה.

לסיכום:

אין אתר מושלם, ועבודות השיפור והתחזוקה לעולם לא נגמרות. אנו צריכים לתעדף את המשימות ולהתרכז במה שמניב יותר תוצאות. הנקודות עליהן הרחבתי לעיל הן השלב הטבעי הבא מיד אחרי עבודת on-page בסיסי, בהצלחה!

מחבר:

אשר אלרן הבעלים של ™Dynamic Search חברת שיווק עסקים בנוניים וגדולים בעיקר בארה"ב. אשר שותף מייסד של Ignitur, תוכנת ניהול משימות למשווקים ועסקים קטנים. לאשר ניסיון רחב בתחום השיווק בעל רקע טכנולוגי וניסיון עיסקי של יותר מעשר שנים.